Uno de mis alumnos me hizo esta pregunta: «Profesor, quiero desarrollarme como científico de datos, ¿Por donde empiezo?«. Mi respuesta inmediata fue: «Te felicito, que bueno saber que tienes claro tu meta profesional, pero vamos por partes, primero cuéntame ¿Qué es lo que sabes de un científico de datos?¿Qué es lo que te gusta de esta profesión?«. Tuvimos una extensa charla, con puntos muy interesantes, compartiendo material sobre el tema y analizando la demanda de este «nuevo oficio» en el mercado local e internacional.

Este tema lo había leído antes de muchas fuentes, sin embargo sentía que había mucha información por ordenar, quería saber que habilidades técnicas e interpersonales debería poseer este profesional y que herramientas debería dominar un verdadero científico de datos.

En el camino encontré artículos muy interesantes de fuentes confiables y otras con un punto de vista distinto pero que aportaban mucho para mi objetivo.

En el año 2012, la conocida Harvard Business Review publicó un artículo denominado «Data Scientist: The Sexiest Job of the 21st Century«. En este artículo se describe como fue la llegada de Jonathan Goldman a LinkedIn en el 2006, y cual fue su aporte a la empresa mediante un arduo trabajo de análisis, interpretación, uso de big data, técnicas estadísticas y descubrimiento de un algoritmo que permitió a LinkedIn desarrollar la famosa funcionalidad «Gente a la que puedes conocer«, por la cual esta conocida red social llegó a incrementar de 8 millones en el 2012, a 450 millones cuentas de usuarios en la actualidad.

Quizás ya tienes una idea de lo que es un Científico de Datos o Data Scientist, y si no es así, el siguiente concepto será definitivo.

«Un Científico de Datos, es la persona que sabe más de estadística que cualquier programador y que a la vez sabe más programación que cualquier estadístico«

De esta manera acertada e ingeniosa fue que Josh Wills, ingeniero de datos de Slack Technologies, hizo referencia a los científicos de datos. Haciendo un resumen, podríamos decir qué «Un Científico de datos, es un profesional dedicada a analizar e interpretar grandes volúmenes de datos«.

Habilidades de un científico de datos

La mayoría de los científicos de datos utilizan una combinación de habilidades todos los días, algunos de los cuales lo han aprendido en el trabajo o de otra manera, generalmente autodidacta. No hay ninguna credencial académica específica que los científicos de datos están obligados a tener.

Todas las habilidades discutidas en esta publicación pueden ser auto-aprendidas. Considérelo una guía sobre cómo convertirse en un científico de datos.

Amor a las Matemáticas

La matemática es una parte importante de la ciencia de los datos.

Asegúrese de conocer los fundamentos de la matemática universitaria desde el cálculo al álgebra lineal. Cuanto más matemáticas conozca, mejor.

Cuando los datos son grandes, a menudo se vuelven difíciles de manejar. Tendrás que usar las matemáticas para procesar y estructurar los datos con los que estás tratando.

Tendrás que entender cómo manipular matrices de datos y obtener una idea general detrás de la matemática de los algoritmos.

Y bueno, ¿Cómo nos ponemos al día con las matemáticas?. Puedes optar por los cursos MOOC que se ofrecen por Internet, aquí una lista de ellos.

El MIT también ofrece un curso abierto específicamente sobre las matemáticas de la ciencia de datos en inglés, pero puedes encontrar mucha información en español en coursera.

Pasión por la Estadística

La estadística es otro de los conocimientos importantes que debes tener en cuenta para poder inferir ideas de pequeños conjuntos de datos a poblaciones más grandes de datos.

La estadística es la ley fundamental de la ciencia de los datos. Las estadísticas pavimentarán su camino sobre cómo convertirse en un científico de datos.

Necesitas saber estadísticas para jugar con los datos. Las estadísticas nos permiten comprender mejor los patrones observados en la data y extraer las ideas que necesita para sacar conclusiones razonables. Por ejemplo, la comprensión estadística inferencial le ayudará a hacer conclusiones generales sobre todo el mundo en una población de una muestra más pequeña.

Para entender la ciencia de los datos debes conocer los fundamentos de las pruebas de hipótesis y diseñar experimentos para entender el significado y el contexto de tus datos.

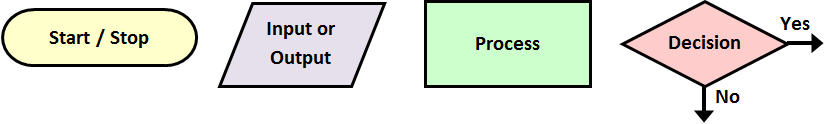

Pensamiento Algorítmico

Los algoritmos son la capacidad de hacer que las computadoras sigan un cierto conjunto de reglas o patrones.

La comprensión de cómo utilizar las máquinas para hacer su trabajo es esencial para procesar y analizar conjuntos de datos demasiado grandes para que la mente humana procese.

Para que pueda hacer cualquier trabajo pesado en la ciencia de los datos, tendrá que entender la teoría detrás de la selección del algoritmo y la optimización. Tendrá que decidir si su problema requiere un análisis de regresión o un algoritmo que ayude a clasificar diferentes puntos de datos en categorías definidas.

Es importante conocer muchos algoritmos diferentes, por ejemplo debes aprender los fundamentos del machine learning. El machine learning es lo que permite a Amazon recomendarle productos basados en su historial de compras sin intervención humana directa. Es un conjunto de algoritmos que utilizarán la potencia de la máquina para descubrir ideas para usted.

El machine learning es lo que permite a Amazon recomendarle productos basados en su historial de compras sin intervención humana directa.

Para hacer frente a conjuntos de datos masivos, necesitará utilizar máquinas para ampliar su pensamiento, ¿muy emocionante cierto?.

Detallista en la Visualización de Datos

Finalizar su análisis de datos es sólo la mitad de la batalla. Para impulsar el impacto, tendrá que convencer a otros a creer y adoptar sus ideas.

«Una imagen vale más que mil palabras».

Los seres humanos son criaturas visuales, casi el 90% de la información transmitida a su cerebro es de naturaleza visual y las imágenes son procesadas 60.000 veces más rápido que el texto, como dice el dicho: «Una imagen vale más que mil palabras».

La visualización de datos ó Data Visualization es el arte de presentar información a través de gráficos y otras herramientas visuales, para que el público pueda interpretar fácilmente los datos y sacar conclusiones de ello.

¿Qué información se presenta mejor en un gráfico de barras y qué tipos de datos debemos presentar en un diagrama de dispersión? Esas son las preguntas que debe hacerse para mejorar su trabajo.

Recuerda que los seres humanos están conectados para responder a señales visuales. Cuanto mejor pueda presentar sus datos, más probable es que alguien tome medidas basadas en ellos.

Échale un vistazo a estas herramientas para data visualization.

Sólidos Conocimientos del Negocio

La data que pueda analizar significan poco sin su contexto. Tienes que entender el negocio que estás analizando.

La claridad en el negocio es la pieza central de cómo convertirse en un científico de datos.

La mayoría de las empresas dependen de sus científicos de datos no sólo para extraer conjuntos de datos, sino también para comunicar sus resultados a las diversas partes interesadas y presentar recomendaciones sobre las que se puede actuar.

Los mejores científicos de datos no sólo tienen la capacidad de trabajar con grandes y complejos volúmenes de datos, sino que también entienden las complejidades de la empresa para la que trabajan.

Tener conocimiento general de negocios les permite hacer las preguntas correctas, y llegar a soluciones eficientes y recomendaciones que son realmente factibles dado cualquier limitación que el negocio podría imponer.

Mente analítica

Para realizar bien tus proyectos de Data Science necesitarás una mentalidad analítica. Una gran cantidad de datos en tus proyectos implica aplicar soluciones a los problemas con una mente rápida y aguda.

Échale un vistazo a Lumosity, es un sitio web que pone a prueba tu capacidad y rapidez mental mediante juegos didácticos, es muy entretenido y divertido.

Muy bien, con todas las habilidades desarrolladas (estoy seguro que lo están poniendo en práctica), ahora necesitarás aprender a usar las herramientas modernas para proyectos Data Science. Cada herramienta tiene sus fortalezas y debilidades, y cada una desempeña un papel diferente en el proceso de la ciencia de datos. Puedes utilizar uno de ellos, o puedes utilizar todos ellos.

Lo que sigue es una amplia visión general de las herramientas más populares en la ciencia de los datos, así como los recursos que necesitará para aprender adecuadamente si desea bucear más profundo.

Herramientas

Formatos de archivos

De seguro sabes que la data se puede almacenar en diferentes formatos de archivo. Éstos son algunos de los más comunes y utilizados:

CSV: (Comma Separated Values), si, son esos archivos cuyos valores están separados por comas. Es posible que hayas abierto este tipo de archivo con Excel antes. Los CSV separan los datos con un delimitador, un signo de puntuación que sirve para separar diferentes datos.

SQL: SQL (Structured Query Language) o Lenguaje Estructurado de Consulta, almacena datos en tablas relacionales. Si va de la derecha a una columna a la izquierda, obtendrá diferentes puntos de datos en la misma entidad (por ejemplo, una persona tendrá un valor en las categorías (columnas) EDAD, GENERO y ESTATURA).

JSON: Javascript Object Notation es un formato de archivo muy utilizado para el intercambio de datos ligero entre sistemas de software y además su estructura es legible por humanos, es decir, si abrimos este archivo, de seguro que sabrás interpretar la información que contiene.

Microsoft Excel

Excel es a menudo la herramienta de entrada a la ciencia de datos, y algo que cada científico de datos puede beneficiarse de su aprendizaje.

Excel le permite manipular fácilmente los datos, ademas podrás realizar ecuaciones en datos sin necesidad de aplicar conocimientos de programación en absoluto. Es una herramienta útil para los analistas de datos que quieren obtener resultados sin programación.

Excel es fácil de empezar, y es un programa que cualquiera que esté en analytics intuitivamente entenderá. Puede ser útil para comunicar datos a personas que pueden no tener ninguna habilidad de programación: todavía deben ser capaces de jugar con los datos.

Por ejemplo, puedes utilizar excel para hacer lo siguiente: Importar de un pequeño conjunto de datos sobre las estadísticas de los resultados de los partidos de fútbol del campeonato local y hacer un gráfico de los máximos goleadores de la liga.

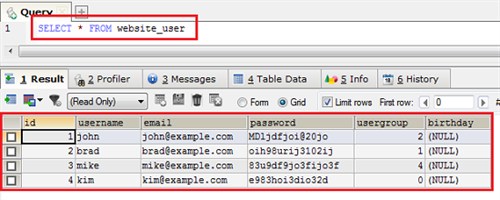

SQL

Todo proyecto de Data Science necesita datos. SQL es un lenguaje de programación especialmente diseñado para manipular y extraer datos de sistemas gestores de bases de datos relacionales, como MySQL, SQL Server, Oracle, etc.

SQL es la herramienta más popular utilizada por los analistas y científicos de datos.

La mayoría de los datos en el mundo se almacenan en tablas que requieren SQL para acceder. Podrás filtrar y ordenar los datos con él.

Por ejemplo, puedes utilizar SQL para realizar una consulta cuyo objetivo sea seleccionar los diez productos más vendidos en la temporada de invierno de una base de datos SQL de una Tienda Comercial.

Python

Python es un poderoso y versátil lenguaje de programación utilizado para múltiples propósitos, desde la creación de sitios y aplicaciones web hasta para proyectos Data Science. Python tiene muchas bibliotecas de código dedicadas a facilitar el trabajo de la ciencia de datos. Python es un lenguaje de programación versátil con una sintaxis simple que es fácil de aprender.

Python es el lenguaje de programación más popular que se enseña en las universidades de Estados Unidos y otros países con un desarrollo acelerado en proyectos tecnológicos.

Muchos científicos de datos usan Python para resolver sus problemas: el 40% de los encuestados en una encuesta definitiva de ciencia de datos realizada por O’Reilly utilizó Python, que era más del 36% que utilizó Excel.

Los ingenieros de datos y los científicos de datos utilizan Python para proyectos de conjuntos de datos de tamaño mediano a grande.

Por ejemplo puedes utilizar Python para consultar tweets de celebridades y luego hacer un análisis de las palabras más frecuentes que se utilizan al aplicar las reglas de programación.

Lenguaje de programación R

R es un entorno y lenguaje de programación diseñado para el análisis de datos. R brilla cuando se trata de construir modelos estadísticos y mostrar los resultados.

R es un elemento básico en la comunidad de ciencias de la información porque está diseñado explícitamente para las necesidades de ciencias de la información. Es el entorno de programación más popular en ciencias de la información con el 43% de los profesionales de datos que lo utilizan.

R es un entorno en el que se puede aplicar una amplia variedad de técnicas estadísticas y gráficas.

La comunidad aporta paquetes que, de forma similar a Python, pueden extender las funciones básicas de la base de código R para que puedan aplicarse a problemas específicos, como medir métricas financieras o analizar datos climáticos.

Los ingenieros de datos y los científicos de datos utilizarán R para conjuntos de datos de tamaño mediano a complejo.

Por ejemplo, puedes utilizar R para representar gráficamente los movimientos del mercado bursátil en los últimos cinco años.

Herramientas Big Data

¿Te imaginas cuánta información almacena Facebook en este momento?. Cuando hablamos de Big Data, hacemos referencia al almacenamiento de grandes volúmenes de datos y a los procedimientos usados para analizar la información y encontrar patrones repetitivos dentro de esos datos.

Cualquier conjunto de datos que es demasiado grande para herramientas de datos convencionales como SQL y Excel puede considerarse Big Data, de acuerdo con McKinsey. La definición más simple es que Big Data son aquellos datos que no caben en su computadora.

Entre las herramientas más usadas en proyectos de Big Data, tenemos:

Hadoop

La historia de Hadoop se inicia cuando Google descubre que requiere urgentemente de una solución que les permita continuar procesando datos al ritmo que crecía de manera exponencial su famoso buscador y todo su ecosistema.

Usando Hadoop, puedes almacenar tus datos en varios servidores mientras lo controlas desde uno.

La solución es una tecnología llamada MapReduce. MapReduce es una abstracción elegante que gestiona una serie de ordenadores como si fuera un único servidor central. Esto le permite almacenar datos en varios equipos, pero procesarlo a través de uno.

Hadoop es un ecosistema de herramientas open source que te permitirán almacenar enormes volúmenes de datos en diferentes servidores. Además le permite administrar mucho más datos de lo que puede en una sola computadora.

Los científicos de datos utilizan Hadoop para manejar grandes conjuntos de datos.

Por ejemplo usando Hadoop podrás almacenar conjuntos de datos masivos que se actualizan en tiempo real, como por ejemplo el número de likes que generan los usuarios de Facebook.

NoSQL

NoSQL hace referencia a los sistemas gestores de base de datos que difieren de almacenar la información de manera relacionada, es decir, administran base de datos con datos no integrados.

NoSQL incluye una gran cantidad de soluciones de almacenamiento de datos que separan grandes conjuntos de datos en trozos manejables.

NoSQL fue una tendencia iniciada por Google para hacer frente a las cantidades increíblemente grandes de datos que estaban almacenando. La información la almacenan en documentos de manera estructurada en el formato JSON, este formato es muy popular para el intercambio de datos entre sistemas. Las soluciones como MongoDB han creado bases de datos que pueden manipularse como tablas SQL, pero que pueden almacenar los datos con menos estructura y densidad.

Los científicos de datos utilizan base de datos NoSQL para almacenar grandes conjuntos de datos, como por ejemplo para almacenar bases de datos de sitios web que tienen millones de usuarios registrados.

Etapas del Proceso Data Science

Cada una de las herramientas tiene sus fortalezas y debilidades, y cada uno puede ser aplicado a diferentes etapas del proceso de un proyecto Data Science.

Para mayor información, te invito a visitar los siguientes enlaces. Si conoces de otras herramientas o tienes experiencia en proyectos de Data Science por favor compártelo en tus comentarios.

Fuentes y Referencias: